Panorama des Référentiels de l’éthique pour les IA

D’où on se place ?

Référentiels

Les Référentiels sont des aides qui permettent d’augmenter la probabilité d’une réponse correcte d’un individu quand les antécédents ordinaires ne suffisent pas à engendrer le comportement.

Divides (Fractures)

Immersion ?

Déclarations

Novembre 2023

Bletchley Declaration

AI Safety Summit international (28 pays)

| accessibility | divide | ethic | inclusive |

| 1 | 1 | 1 | 6 |

De nombreux risques liés à l’IA sont intrinsèquement de nature internationale et il est donc préférable de les gérer par la coopération internationale. Nous sommes résolus à travailler ensemble de manière inclusive pour garantir une IA centrée sur l’humain, fiable et responsable.

Ce faisant, nous reconnaissons que les pays devraient considérer l’importance d’une approche de gouvernance et de réglementation favorable à l’innovation et proportionnée qui maximise les avantages et prend en compte les risques associés à l’IA.

Septembre 2024

Global Digital Compact

Nations Unies

| accessibility | divide | ethic | inclusive |

| 1 | 10 | 1 | 26 |

REF: 1

Les technologies numériques transforment radicalement notre monde. Elles offrent d’immenses avantages potentiels pour le bien-être et le progrès des personnes et des sociétés, ainsi que pour notre planète. Ils promettent d’accélérer la réalisation des objectifs de développement durable.

REF: 2

Nous n’y parviendrons que par une coopération internationale renforcée qui combler toutes les fractures numériques entre les pays et à l’intérieur de ceux-ci. Nous sommes conscients des défis que ces fractures posent à de nombreux pays, en particulier aux pays en développement, dont les besoins de développement sont pressants et les ressources limitées.

Septembre 2024

Issue Note - Sherpa track G20 South Africa 2025

Digital Economy Working Group - G20

| accessibility | divide | ethic | inclusive |

| 0 | 0 | 2 | 11 |

https://g20.org/wp-content/uploads/2024/12/Issue-Note_Digital-Economy-WG.pdf

REF: Priorité 4

Reconnaissant que les décisions d’aujourd’hui façonnent les perspectives de prospérité de demain, l’Afrique du Sud concentrera les discussions sur les questions éthiques et politiques, notamment en ce qui concerne le secteur privé et les plateformes de médias sociaux.

Afin de répondre à la nécessité d’institutionnaliser les garanties et les évaluations de l’impact sur les droits de l’homme, conformément aux principes directeurs des Nations unies relatifs aux entreprises et aux droits de l’homme.

REF: Priorité 4

Une considération essentielle est la partialité et la discrimination qui peuvent résulter de la conception des algorithmes, en particulier des ensembles de données utilisés pour former les algorithmes dont la grande majorité des Africains est exclue.

Septembre 2024

Declaration on digital inclusion for all

Digital Economy Working Group - G20

| accessibility | divide | ethic | inclusive |

| 7 | 8 | 7 | 28 |

REF: 17

Nous reconnaissons que l’intelligence artificielle (IA) sûre, sécurisée et fiable, lorsqu’elle est appliquée de manière transparente, éthique, responsable et fiable, peut servir de catalyseur pour parvenir à la croissance économique et à un développement durable inclusif dans ses 3 dimensions : sociale, économique et environnementale.

Nous réaffirmons les principes du G20 en matière d’IA et la recommandation de l’UNESCO sur l’éthique de l’IA.

Référentiels

Novembre 2021

Recommandation sur l’éthique de l’intelligence artificielle

UNESCO

| accessibility | divide | ethic | inclusive |

| 0 | 30 | 33 | 10 |

REF: 50

Les États membres devraient mettre en place des cadres relatifs aux évaluations de l’impact tels que l’évaluation de l’impact éthique, pour identifier et analyser les avantages et les risques des systèmes d’IA , ainsi que des mesures appropriées de prévention, d’atténuation et de suivi des risques, entre autres mécanismes de certification. Ces évaluations de l’impact devraient mettre en évidence les répercussions sur les droits de l’homme et les libertés fondamentales, notamment les droits des personnes marginalisées et vulnérables ou en situation de vulnérabilité, le droit du travail, l’environnement et les écosystèmes ainsi que les incidences éthiques et sociales, et faciliter la participation citoyenne.

REF: 51

Les États membres et les entreprises du secteur privé devraient mettre en place des mécanismes de diligence requise et de supervision pour identifier, prévenir et atténuer les risques et rendre compte de la manière dont ils traitent les répercussions des systèmes d’IA sur le respect des droits de l’homme, l’état de droit et les sociétés inclusives. Les États membres devraient également être capables d’évaluer les effets socioéconomiques des systèmes d’IA sur la pauvreté et de s’assurer que le fossé entre les riches et les pauvres, ainsi que la fracture numérique entre les pays et à l’intérieur de ceux-ci, ne s’accentuent pas avec l’adoption massive des technologies de l’IA.

REF: 52

Les gouvernements devraient adopter un cadre réglementaire qui définisse une procédure permettant en particulier aux autorités publiques de mener à bien des évaluations sur l’impact des systèmes d’IA afin d’anticiper les répercussions, d’atténuer les risques, d’éviter les conséquences préjudiciables, faciliter la participation des citoyens et de faire face aux défis sociétaux.

Juillet 2024

Artificial Intelligence Risk Management Framework: Generative Artificial Intelligence Profile

NIST

| accessibility | divide | ethic | inclusive |

| 1 | 1 | 7 | 2 |

REF: MP-3.4-006

Impliquer les utilisateurs finaux, les praticiens et les opérateurs du système GAI dans les activités de prototypage et d’essai. Veillez à ce que ces tests couvrent différents scénarios, tels que des situations de crise ou des contextes sensibles sur le plan éthique.

Risques : Configuration homme-IA ; Intégrité de l’information ; biais nuisibles et homogénéisation ; contenu dangereux, dangereux, violent ou haineux

2023

ISO/IEC 42001:2023

ISO

REF: Annexe 2

Elle aborde les défis uniques que pose l’IA, notamment les considérations éthiques, la transparence et l’apprentissage continu. Elle propose aux organismes une méthodologie structurée pour gérer les risques et opportunités associés à l’IA, tout en conciliant innovation et gouvernance.

MAIS c’est payant !

2019 (V2)

A Vision for Prioritizing Human Well-being with Autonomous and Intelligent Systems

IEEE

| accessibility | divide | ethic | inclusive |

| 1 | 5 | 500 | 28 |

REF: Accès à l'éthique classique par les entreprises et les sociétés

Combler le fossé linguistique entre les techniciens, les philosophes et les décideurs politiques. Comprendre les nuances du langage philosophique est crucial, qu’il s’agisse de l’IoT, de la vie privée, de la cybersécurité ou de la gouvernance de l’internet.

REF: L'application des traditions éthiques bouddhistes classiques à la conception de l'IA

Selon le bouddhisme, l’éthique consiste à se comporter de manière à ce que le sujet atteigne en fin de compte réaliser l’objectif de la libération. La question « Comment dois-je agir ? » trouve une réponse directe…

Avril 2024

RGESN

ARCEP, DINUM, ADEME

| accessibility | divide | ethic | inclusive |

| 0 | 1 | 0 | 0 |

https://ecoresponsable.numerique.gouv.fr/publications/referentiel-general-ecoconception/

REF: 1.1

Prendre en compte l’utilité du service numérique dès sa conception et son inscription dans au moins l’un des objectifs de développement durable (ODD), l’un des enjeux de limites planétaires ou tout autre référentiel du même type.

Vérifier par exemple un ou plusieurs de ces points : la pertinence du service, son utilité, sa création de valeur, son bien-fondé, son service pour l’intérêt général, sa réponse à des besoins essentiels, sa participation à la mise en place de communs numériques, etc.

Il convient d’afficher dans la déclaration d’écoconception les ODD dans lequel le service s’inscrit.

Juin 2024

Référentiel général pour l'IA frugale pour mesurer et réduire l'impact environnemental de l'IA

AFNOR

| accessibility | divide | ethic | inclusive |

| 0 | 0 | 2 | 0 |

https://www.afnor.org/actualites/referentiel-pour-mesurer-et-reduire-impact-environnemental-de-ia/

REF: BP01

Utiliser des méthodes d’analyse de besoin pour mettre en œuvre la frugalité.

L’usage de l’I! doit être motivé Ŕar la confirmation du besoin via une méthode centrée sur l’utilisateur : ´ l’emŔloi d’une solution IA pour rÈpondre ‡ quel usage/finalitÈ ?

Prise en compte des critËres 1.1 et 1.2 du RGESN

REF: BP02

Choisir et dÈvelopper la solution pour rÈpondre spÈcifiquement au besoin, en considÈrant les alternatives ‡ l’IA

Challenger les besoins exprimÈs par les utilisateurs et notamment la performance et la qualitÈ des rÈsultats pour arriver aux besoins fondamentaux et permettre de proposer diverses approches et non uniquement celles basées sur l’I! (voir également la bonne Ŕratique N∞ 01). Les besoins doivent Ítre formulÈs de telle sorte que toutes les solutions, IA et non-IA, soient possibles.

Septembre 2021

RIA31 Référentiel IA Ethique et Responsable

Institut du numérique responsable

| accessibility | divide | ethic | inclusive |

| 0 | 0 | 4 | 0 |

Un comité éthique & environnemental est-il mis en place ? Les référents pluridisciplinaire (juristes, RSE, métiers, data scientist, data ingénieur, sociologues, …), sont-ils identifiés et intégrés dans une gouvernance RSE ? L’éthique, la déontologie, la tracabilité des sources et la finalité de l’IA sont-elles suivies ?

Est-ce qu’une matrice d’éligibilité aux 7 éléments essentiels pour qualifier une IA de confiance au regard de la commission européenne (IA Act - 2026) est instanciée ? La transparence, l’éthique, équitable, securité, explicabilité, robustesse, gouvernance de données et données privées sont-elles prises en compte ?

La responsabilité légale et éthique du résultat de l’IA, et les nécessités d’intervention humaine pour exploiter ce résultat sont-elles identifiées ?

Septembre 2024

Recommandations de sécurite pour un systeme d'IA générative

ANSSI

| accessibility | divide | ethic | inclusive |

| 0 | 0 | 0 | 0 |

https://cyber.gouv.fr/publications/recommandations-de-securite-pour-un-systeme-dia-generative

REF: R15

Prévoir un mode dégradé des services métier sans système d’IA

Afin de prévenir des dysfonctionnements ou des incohérences dans les réponses apportées par le modèle d’IA, il est recommandé de prévoir au minimum une procédure de contournement du système d’IA pour les utilisateurs, afin de répondre aux besoins métier.

Rapports

Septembre 2024

Governing AI for humanity

AI Advisory Body

| accessibility | divide | ethic | inclusive |

| 0 | 30 | 33 | 10 |

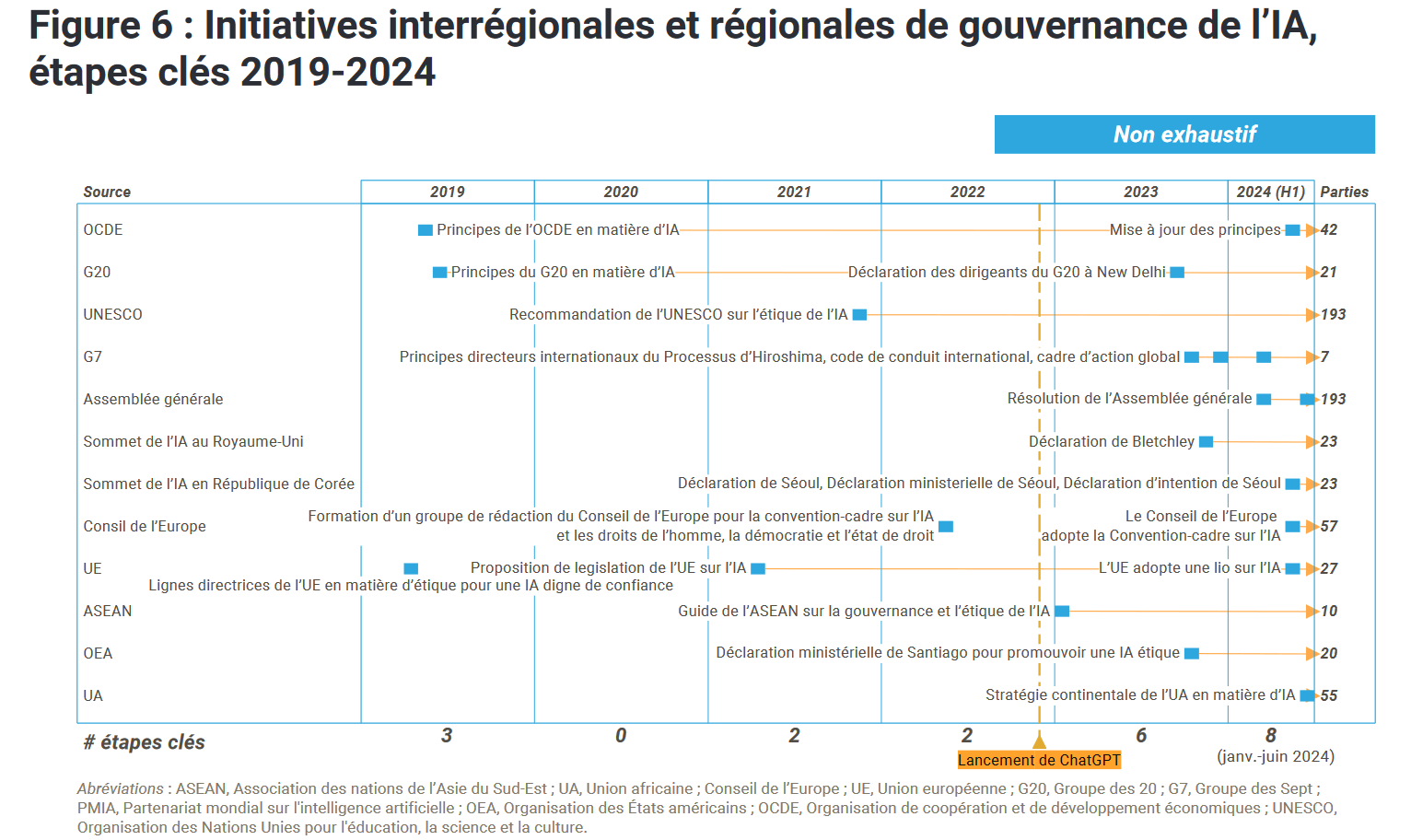

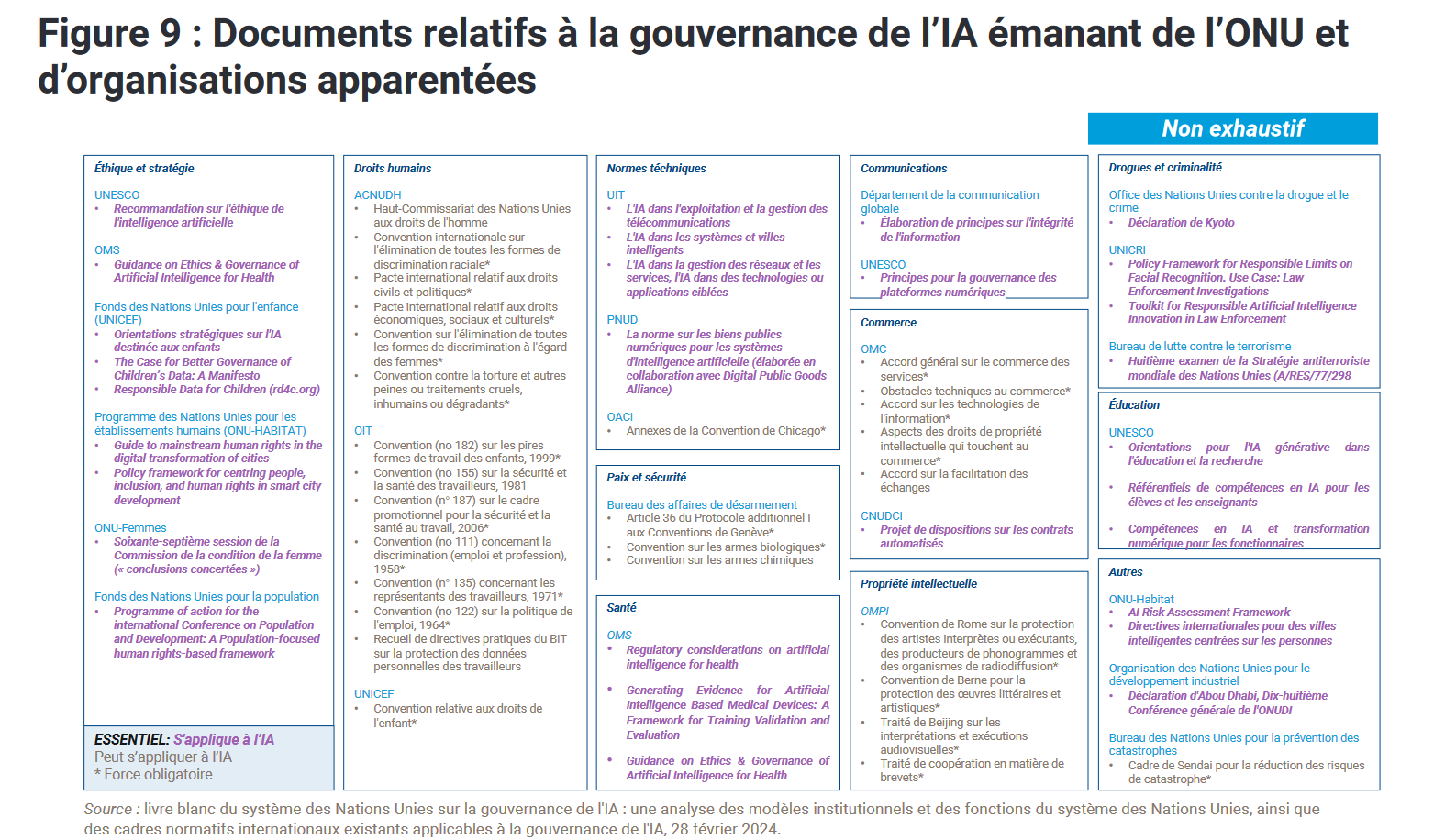

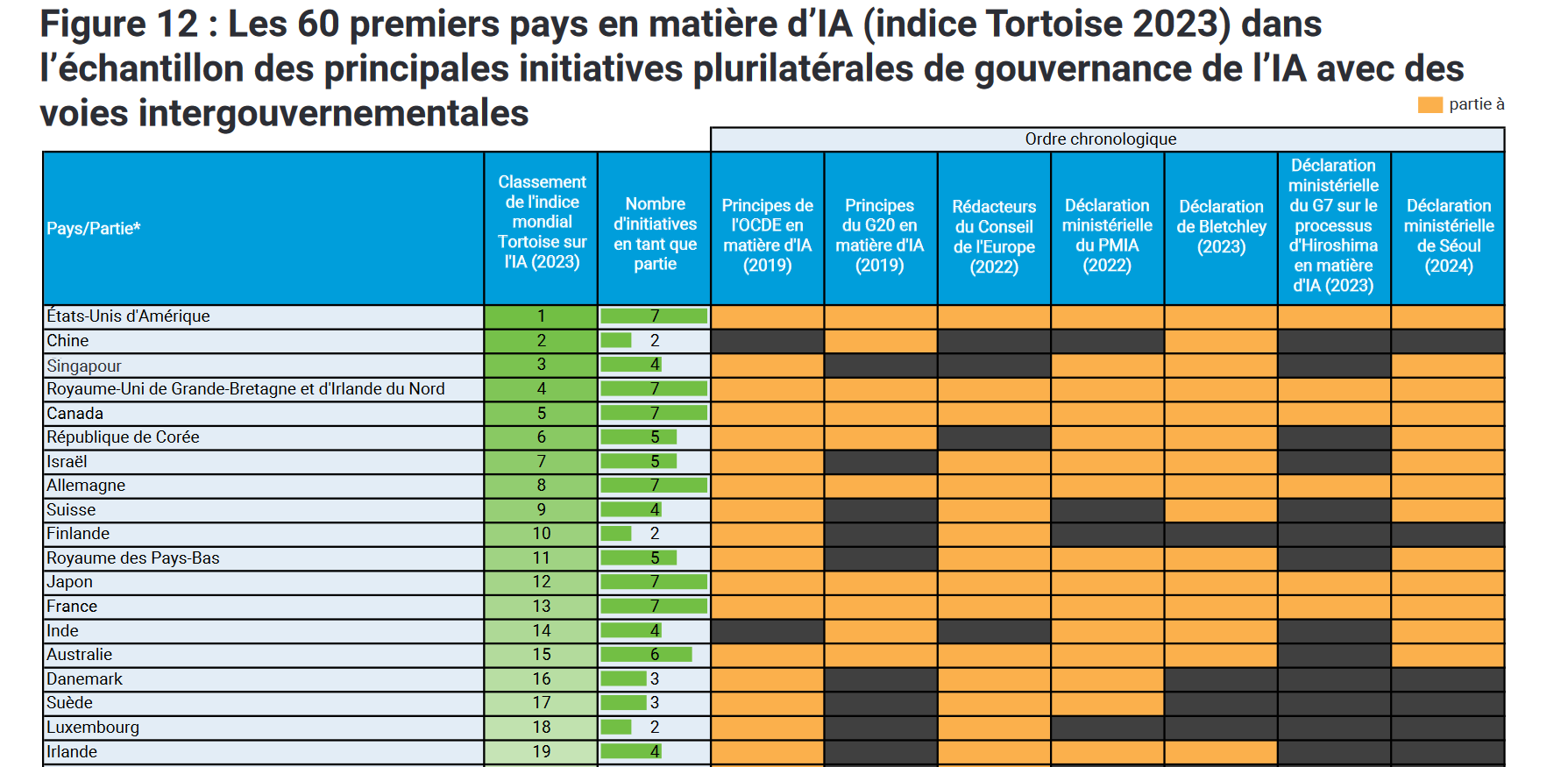

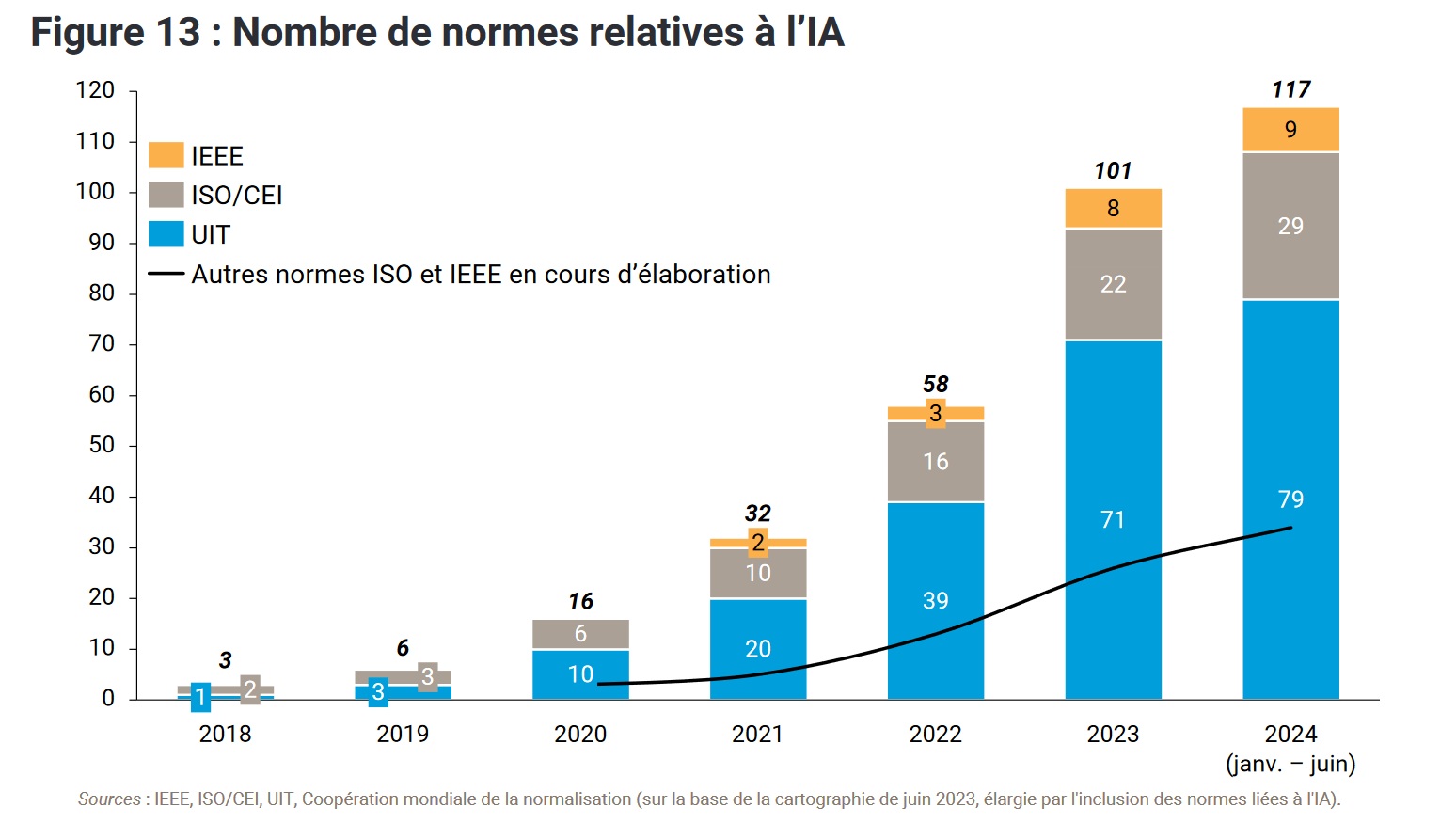

REF: 44

Il existe aujourd’hui un déficit de gouvernance mondiale en ce qui concerne l’IA. Malgré de nombreuses discussions sur l’éthique et les principes, la mosaïque de normes, d’institutions et d’initiatives est encore naissante et pleine de lacunes. La responsabilité et les recours en cas de préjudice se distinguent souvent par leur absence.

Le respect des règles repose sur le volontariat. Il existe un décalage fondamental entre la rhétorique de haut niveau, les systèmes développés, déployés et utilisés, et les conditions requises pour la sécurité et l’inclusion…

REF: 61

Le manque de coordination entre les initiatives et les organismes risque de diviser le monde en régimes de gouvernance de l’IA déconnectés et incompatibles.

REF: 72

L’émergence et l’évolution constantes des initiatives de gouvernance de l’IA ne garantissent pas une collaboration efficace au bénéfice de l’humanité.

Risques

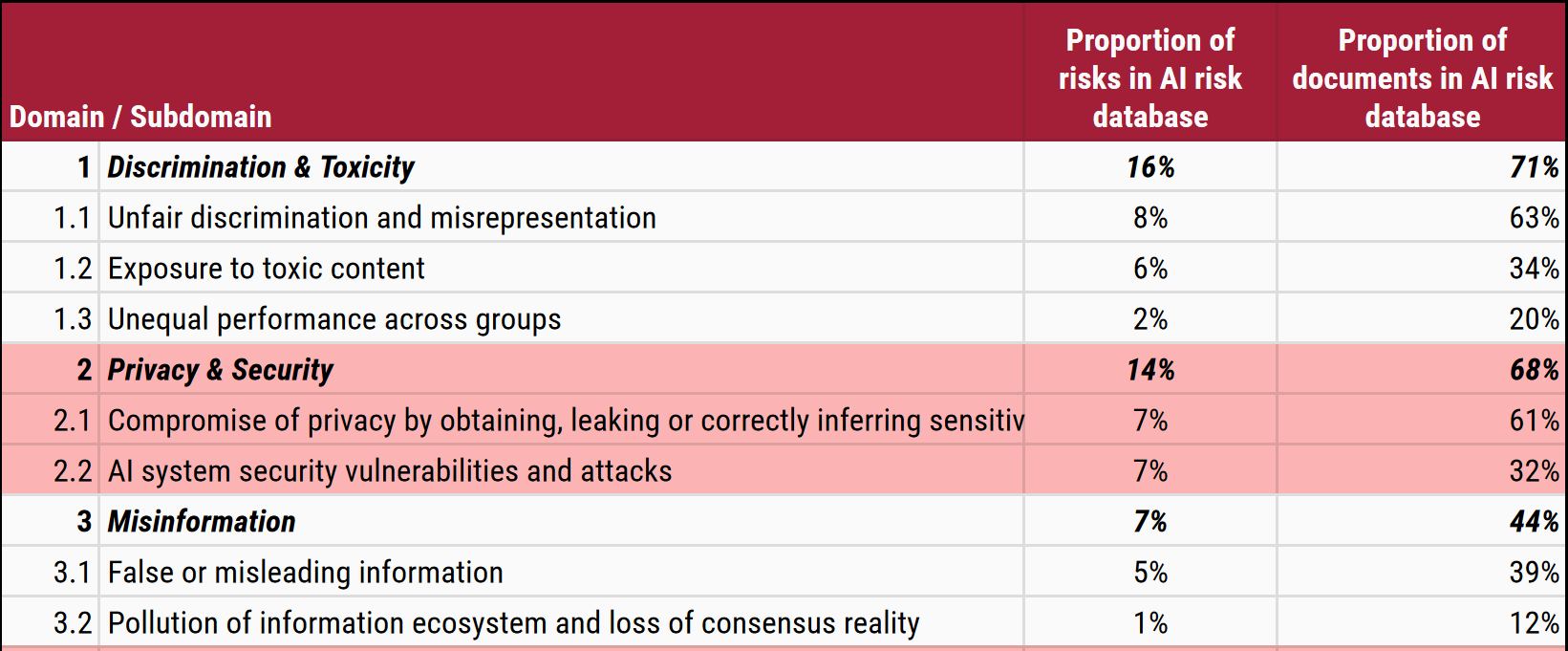

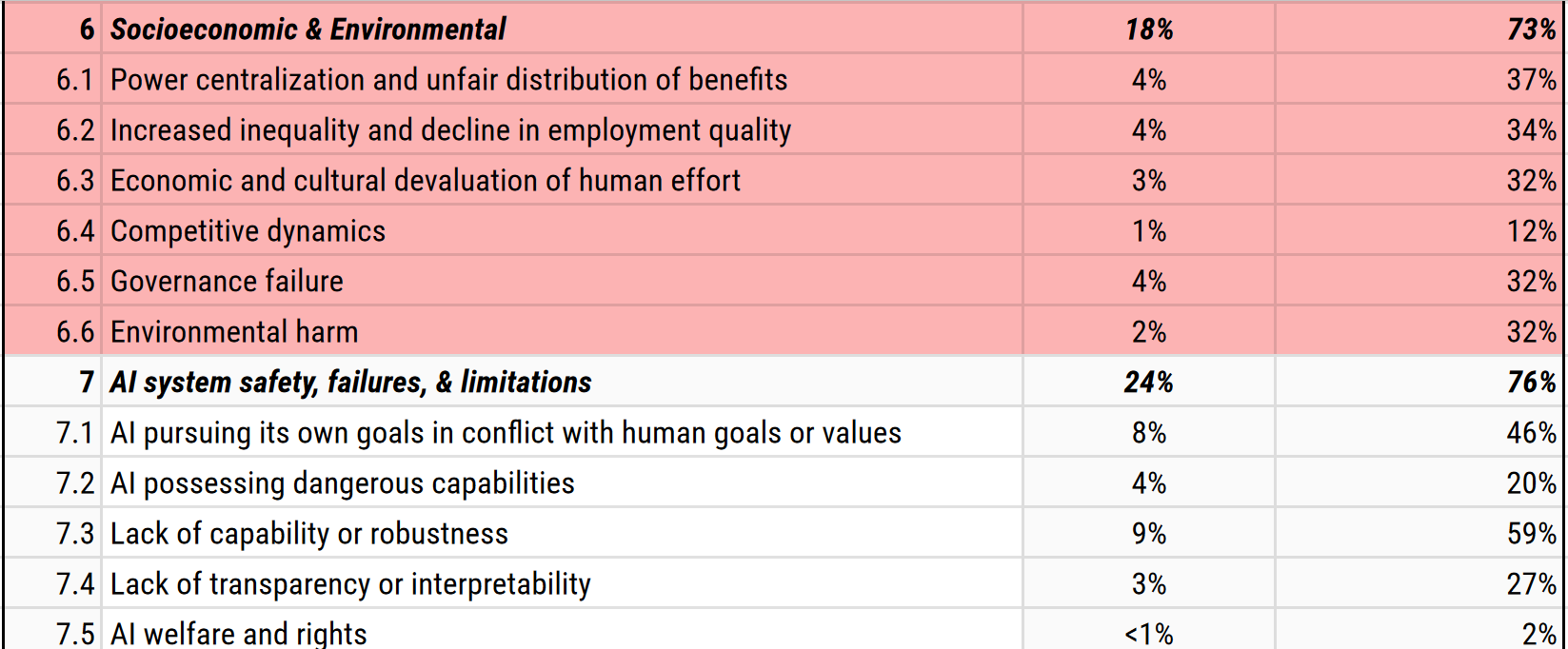

Août 2024

IA risks

MIT

| accessibility | divide | ethic | inclusive |

| 0 | 0 | 41 | 4 |

Lois

Mai 2024

Pre-Rulemaking Considerations for Anti-Discrimination in AI Act

Colorado State

| discrimination | ethic |

| 26 | 0 |

Lorsqu’un système d’intelligence artificielle est déployé et « apporte ou constitue un facteur substantiel » en prenant une décision conséquente », il est considéré comme un « système d’intelligence artificielle à haut risque ».

Une « décision consécutive » est une décision qui a un « effet juridique important ou un effet tout aussi important ».

Comme à une inscription à l’école ou une opportunité d’éducation ; un emploi ou une opportunité d’emploi ; un service financier ou de prêt; un service gouvernemental essentiel; services de soins de santé; logement; assurance; ou un service juridique.

Mai 2024

AI Act

Union Européenne

| accessibility | discrimination | ethic |

| 10 | 17 | 3 |

REF: Article 5

La mise sur le marché, la mise en service ou l’utilisation d’un système d’IA qui exploite les vulnérabilités d’une personne physique ou d’un groupe spécifique de personnes en raison de leur âge, d’un handicap ou d’une situation sociale ou économique particulière, avec pour objectif ou pour effet d’altérer de manière significative le comportement de cette personne ou d’une personne appartenant à ce groupe d’une manière qui cause ou est raisonnablement susceptible de causer à cette personne ou à une autre personne un préjudice important

REF: Article 12

Veiller à ce que le système d’IA à haut risque soit conforme aux exigences en matière d’accessibilité conformément aux directives (UE) 2016/2102 et (UE) 2019/882.

Est-ce éthique ?

CNIL

Les 6 recommandations

- Formation à l’éthique tous les acteurs clefs

- Rendre les syst. algo compréhensibles

- Design des syst. algo au service de la liberté humaine

Les 6 recommandations

- Une plateforme nationale d’audit des algorithmes ;

- Recherche sur l’IA éthique et lancer une grande cause nationale participative autour d’un projet de recherche d’intérêt général

- Renforcer la fonction éthique au sein des entreprises

Algorithmes et intelligence artificielle permettent la délégation croissante de tâches, de raisonnements ou de décisions de plus en plus critiques à des machines. Souvent jugées infaillibles et « neutres », celles-ci n’ouvrent-elles pas la voie à une confiance excessive et à la tentation pour chacun de ne pas exercer pleinement ses responsabilités ?

Comment faire face aux formes nouvelles de dilution de la responsabilité qu’impliquent des systèmes algorithmiques complexes et très segmentés ?

La malédiction de la récurrence - l’entraiment sur les données générées résulte que les modèles oublient

Nous constatons que l’utilisation d’un contenu généré par un modèle lors de l’entraiment provoque des défauts irréversibles dans les modèles résultants.

The curse of recursion: training on generated data makes models forget

Plus une caractéristique culturelle est inhabituelle, moins elle a de chances d’être mise en évidence dans la représentation de la culture par un grand modèle. L’IA nous conduit à un aplatissement, effaçant les particularités qui nous distinguent. Henri Farrell

Contrairement à son apport dans le monde logiciel, l’ouverture de l’IA, elle, repose sur un ensemble de couches plus complexes, dont les modalités d’ouverture et de transparence minimales ne sont pas construites.